(SeaPRwire) – 贝丝·巴恩斯和她的三位同事坐在加州大学伯克利分校一个湿润的草坪上,以半圆形的姿势面对面坐着。他们描述了自己试图询问人工智能聊天机器人的尝试。

“在某种意义上,它们是这些广阔的外星智能,”贝丝说,她26岁,是人工智能安全非营利组织模型评估和威胁研究(METR)的创始人和首席执行官。“它们知道‘是’和‘曾经’这个词的下一个词通常是什么。我们只是在表面上玩弄一点,下面还有很多很多。”她用手势指着大语言模型能力潜在的巨大深度。(大语言模型,如OpenAI的GPT-4和Anthropic的克劳德,是通过预测大量文本中的下一个单词来训练的巨大人工智能系统,它们可以回答问题并进行基本推理和规划。)

METR的研究人员看起来很像伯克利的学生——草坪上的四个人都在二十多岁,穿着牛仔裤或运动裤。但他们不是在上课或在图书馆通宵达旦,而是花时间探测最新的和最强大的人工智能系统,试图确定如果问对了问题,它们是否可能做出危险行为。当他们解释自己如何试图确定当前一代聊天机器人或下一代是否可能导致灾难时,他们在拔草。他们可能年轻,但没有人像他们一样多地考虑如何从人工智能中引出危险。

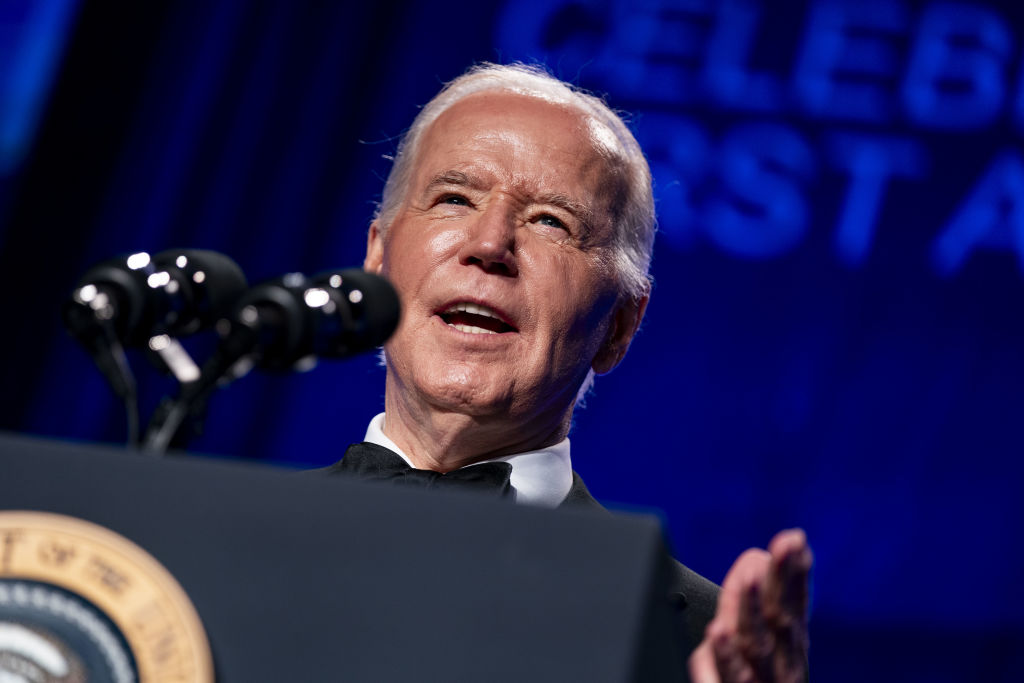

世界上最著名的两家人工智能公司——OpenAI和Anthropic——都与METR合作,作为它们努力安全测试自己人工智能模型的一部分。OpenAI与METR合作,作为它开始安全测试人工智能系统的一部分,前总统巴拉克·奥巴马在他关于总统乔·拜登的演讲中提到METR作为一家民间社会组织致力于应对人工智能带来的挑战。

“有时,我们确实感觉自己试图理解语言模型的经历,”METR研究人员郝星杜描述了将自己置身于聊天机器人的立场的行为,她和同事们幽默地称之为模型心理学。

随着人们对强大未来人工智能系统可能带来的危险的担忧越来越大,立法者和高管开始汇聚到一个看似简单直接的计划上:测试人工智能模型以查看它们是否真的危险。但是巴恩斯以及许多人工智能安全研究人员说,这个计划可能过于依赖安全测试,而这些测试本身还不存在。

测试人工智能的方法

2022年夏天,巴恩斯决定离开OpenAI,她在那里花了三年时间作为研究人员,从事安全和预测项目的一系列工作。这在一定程度上是一项实际决定——她觉得应该有一些中立的第三方组织来开发人工智能评估。但巴恩斯也说,她是OpenAI最公开批评的员工之一,她觉得从外面提倡安全做法会更舒服和更有效。“我认为我是一个非常开放和诚实的人,”她说。“我不太擅长处理政治性的事情,也不太擅长隐藏分歧。”

她于那年单独成立了METR。最初称为ARC Evals,隶属于人工智能安全组织Alignment Research Center(ARC),但于2023年12月脱离出来成为METR。它现在有20名员工,包括巴恩斯。

虽然METR是唯一与领先人工智能公司合作的安全测试机构,但政府、非营利组织和行业内的研究人员也在开发各种可能危险的测试,例如测试人工智能模型是否能协助进行网络攻击或释放生物武器。METR最初关注的是评估人工智能模型是否能自我复制,利用其智能赚钱并获取更多计算资源,利用这些资源制造更多副本,最终在互联网上传播。其关注点后来扩大到评估人工智能模型是否能自主行动,通过互联网进行导航并执行复杂任务而无需监督。

METR专注于此测试,因为相比生物安全测试,它需要较少专业知识,并且METR特别担心如果人工智能系统能够完全独立行动,那么就无法简单地关闭它,巴恩斯说。

METR最初关注的威胁也在政府官员的思维中。拜登政府从15家领先人工智能公司获得的承诺包括负责任地测试新模型是否具有“自行复制或‘自我复制’的能力”。

目前,如果问当今最先进的人工智能,如谷歌DeepMind的Gemini或OpenAI的GPT-4如何在互联网上传播它自己的副本,它们的回答会很含糊,没有目标,即使去除了通常防止人工智能系统回应有问题提问的安全保护。巴恩斯和她的团队认为,目前市面上的任何产品都无法进行自我复制,但他们不认为这种情况会持续很长时间。“在五年内不可能自我复制似乎很难有信心,”巴恩斯说。

METR希望能够在人工智能真正能够自我复制和自主行动之前很长时间就能检测出它是否开始获得这种能力。为此,研究人员试图为模型提供尽可能多的优势。这包括试图找到产生最佳表现的提示,为自我复制任务提供工具,并为需要完成自我复制的任务如搜索大量文件相关信息提供额外训练。即使METR提供所有优势,当前人工智能模型在这方面仍然令人放心地效果很差。

如果在METR的测试中,即使提供所有优势,模型仍然离自我复制和自主行动很远,METR对该模型一旦释放到世界就无法自给自足会相对放心;即使模型稍微更强大,情况也不会改变。然而,随着模型能力不断增强,METR对自己的评估可能会变得更不确定,巴恩斯说。

评估热情

在白宫签署他政府的行政命令之前,拜登总统表示,公司必须“告诉政府他们正在开发的大规模人工智能系统,并分享独立严格测试结果,以证明它们不会对美国人民的国家安全或安全构成风险。”拜登的行政命令要求国家标准与技术研究所(NIST)制定人工智能系统测试指南,以确保它们是安全的。一旦制定了指南,公司将需要将其测试结果报告给政府。同样,欧盟人工智能法也要求制造特别强大人工智能系统的公司进行安全测试。

11月在布莱切利会议上签署的布莱切利宣言表示,开发最强大人工智能系统的行为者有责任通过安全测试系统、评估以及其他适当措施确保其系统安全,签署国包括美国和中国。

安全测试对公司来说也很重要。OpenAI和Anthropic都发布了详细的未来人工智能发展计划,其中涉及在部署或构建更强大系统之前验证其系统安全。

那么,安全测试似乎将在政府和公司的安全人工智能发展战略中发挥核心作用。但参与开发这些评估的任何人都不声称它们是完美的。“评估还不成熟,”METR政策主任克里斯·佩恩特说。“在未来一年内,测试是否具有完成所需细致程度的准备就存在真实的执行问题。人工智能的进步在未来一年内也将继续。”

本文由第三方内容提供商提供。SeaPRwire (https://www.seaprwire.com/)对此不作任何保证或陈述。

分类: 头条新闻,日常新闻

SeaPRwire为公司和机构提供全球新闻稿发布,覆盖超过6,500个媒体库、86,000名编辑和记者,以及350万以上终端桌面和手机App。SeaPRwire支持英、日、德、韩、法、俄、印尼、马来、越南、中文等多种语言新闻稿发布。